Sim 会自动计算所有工作流执行的成本,提供基于 AI 模型使用和执行费用的透明定价。了解这些成本有助于您优化工作流并有效管理预算。

成本如何计算

每次工作流执行包括两个成本组成部分:

基础执行费用:每次执行 $0.001

AI 模型使用费用:基于令牌消耗的可变成本

modelCost = (inputTokens × inputPrice + outputTokens × outputPrice) / 1,000,000

totalCost = baseExecutionCharge + modelCostAI 模型的价格是按每百万令牌计算的。计算时会除以 1,000,000 得出实际成本。不包含 AI 模块的工作流仅需支付基础执行费用。

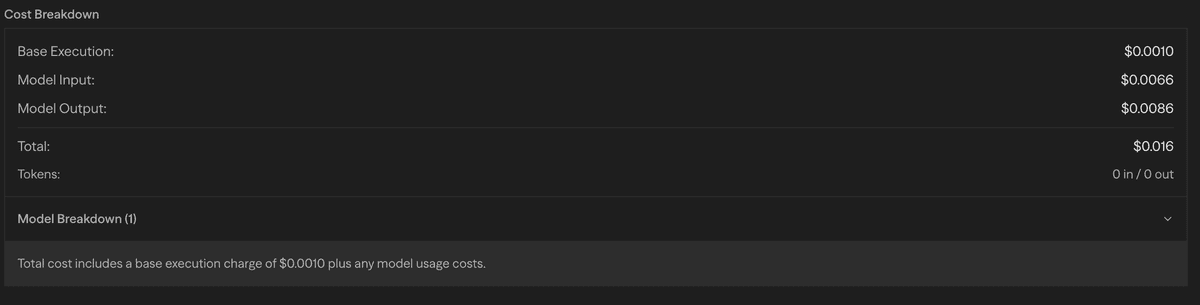

日志中的模型成本明细

对于使用 AI 模块的工作流,您可以在日志中查看详细的成本信息:

模型成本明细显示:

- 令牌使用量:每个模型的输入和输出令牌数量

- 成本明细:每个模型和操作的单独成本

- 模型分布:使用了哪些模型以及使用次数

- 总成本:整个工作流执行的总成本

定价选项

托管模型 - Sim 为 Agent 模块提供 API Key,价格乘以 1.4 倍:

OpenAI

| 模型 | 基础价格(输入/输出) | 托管价格(输入/输出) |

|---|---|---|

| GPT-5.1 | $1.25 / $10.00 | $1.75 / $14.00 |

| GPT-5 | $1.25 / $10.00 | $1.75 / $14.00 |

| GPT-5 Mini | $0.25 / $2.00 | $0.35 / $2.80 |

| GPT-5 Nano | $0.05 / $0.40 | $0.07 / $0.56 |

| GPT-4o | $2.50 / $10.00 | $3.50 / $14.00 |

| GPT-4.1 | $2.00 / $8.00 | $2.80 / $11.20 |

| GPT-4.1 Mini | $0.40 / $1.60 | $0.56 / $2.24 |

| GPT-4.1 Nano | $0.10 / $0.40 | $0.14 / $0.56 |

| o1 | $15.00 / $60.00 | $21.00 / $84.00 |

| o3 | $2.00 / $8.00 | $2.80 / $11.20 |

| o4 Mini | $1.10 / $4.40 | $1.54 / $6.16 |

Anthropic

| 模型 | 基础价格(输入/输出) | 托管价格(输入/输出) |

|---|---|---|

| Claude Opus 4.5 | $5.00 / $25.00 | $7.00 / $35.00 |

| Claude Opus 4.1 | $15.00 / $75.00 | $21.00 / $105.00 |

| Claude Sonnet 4.5 | $3.00 / $15.00 | $4.20 / $21.00 |

| Claude Sonnet 4.0 | $3.00 / $15.00 | $4.20 / $21.00 |

| Claude Haiku 4.5 | $1.00 / $5.00 | $1.40 / $7.00 |

| 模型 | 基础价格(输入/输出) | 托管价格(输入/输出) |

|---|---|---|

| Gemini 3 Pro Preview | $2.00 / $12.00 | $2.80 / $16.80 |

| Gemini 2.5 Pro | $1.25 / $10.00 | $1.75 / $14.00 |

| Gemini 2.5 Flash | $0.30 / $2.50 | $0.42 / $3.50 |

1.4 倍的系数涵盖了基础设施和 API 管理成本。

使用您自己的 API 密钥 - 以基础价格使用任何模型:

| 提供商 | 示例模型 | 输入 / 输出 |

|---|---|---|

| Deepseek | V3, R1 | $0.75 / $1.00 |

| xAI | Grok 4 最新版, Grok 3 | $3.00 / $15.00 |

| Groq | Llama 4 Scout, Llama 3.3 70B | $0.11 / $0.34 |

| Cerebras | Llama 4 Scout, Llama 3.3 70B | $0.11 / $0.34 |

| Ollama | 本地模型 | 免费 |

| VLLM | 本地模型 | 免费 |

直接向提供商支付,无额外加价

显示的价格为截至 2025 年 9 月 10 日的费率。请查看提供商文档以获取最新价格。

自带密钥(BYOK)

你可以在 设置 → BYOK 中为托管模型(OpenAI、Anthropic、Google、Mistral)使用你自己的 API 密钥,以按基础价格计费。密钥会被加密,并在整个工作区范围内生效。

成本优化策略

- 模型选择:根据任务复杂度选择合适的模型。简单任务可用 GPT-4.1-nano,复杂推理可选 o1 或 Claude Opus。

- 提示工程:结构清晰、简洁的提示能减少 token 使用量,同时保证质量。

- 本地模型:对于非关键任务,使用 Ollama 或 VLLM,可完全消除 API 成本。

- 缓存与复用:将常用结果存储在变量或文件中,避免重复调用 AI 模型。

- 批量处理:一次 AI 请求处理多个项目,减少单独调用次数。

使用监控

你可以在 设置 → 订阅 中监控你的用量和账单:

- 当前用量:当前周期的实时用量和费用

- 用量上限:带有可视化进度指示的套餐限制

- 账单明细:预计费用和最低承诺金额

- 套餐管理:升级选项和账单历史

编程方式用量追踪

你可以通过 API 以编程方式查询当前用量和限制:

接口地址:

GET /api/users/me/usage-limits认证方式:

- 在

X-API-Keyheader 中包含你的 API 密钥

请求示例:

curl -X GET -H "X-API-Key: YOUR_API_KEY" -H "Content-Type: application/json" https://sim.ai/api/users/me/usage-limits响应示例:

{

"success": true,

"rateLimit": {

"sync": {

"isLimited": false,

"requestsPerMinute": 25,

"maxBurst": 50,

"remaining": 50,

"resetAt": "2025-09-08T22:51:55.999Z"

},

"async": {

"isLimited": false,

"requestsPerMinute": 200,

"maxBurst": 400,

"remaining": 400,

"resetAt": "2025-09-08T22:51:56.155Z"

},

"authType": "api"

},

"usage": {

"currentPeriodCost": 12.34,

"limit": 100,

"plan": "pro"

}

}限流字段:

requestsPerMinute:持续速率限制(token 按此速率补充)maxBurst:你可累计的最大 token 数(突发容量)remaining:当前可用 token 数(最多可达maxBurst)

响应字段:

currentPeriodCost反映当前账单周期的用量limit来源于个人限额(Free/Pro)或组织池化限额(Team/Enterprise)plan是与你的用户关联的最高优先级的激活套餐

套餐限制

不同的订阅套餐有不同的使用限制:

| 套餐 | 每月使用额度 | 速率限制(每分钟) |

|---|---|---|

| Free | $20 | 5 sync,10 async |

| Pro | $100 | 10 sync,50 async |

| Team | $500(共享) | 50 sync,100 async |

| Enterprise | 自定义 | 自定义 |

计费模式

Sim 采用基础订阅 + 超额计费模式:

计费方式说明

Pro 套餐($20/月):

- 月度订阅包含 $20 使用额度

- 使用未超过 $20 → 无额外费用

- 使用超过 $20 → 月底结算超额部分

- 示例:$35 使用 = $20(订阅)+ $15(超额)

Team 套餐($40/人/月):

- 团队成员共享使用额度

- 超额费用按团队总用量计算

- 账单由组织所有者统一支付

Enterprise 套餐:

- 固定月费,无超额费用

- 使用额度可按协议定制

阈值计费

当未结算的超额费用达到 $50 时,Sim 会自动结算全部未结算金额。

示例:

- 第 10 天:超额 $70 → 立即结算 $70

- 第 15 天:新增 $35 使用(累计 $105)→ 已结算,无需操作

- 第 20 天:再用 $50(累计 $155,未结算 $85)→ 立即结算 $85

这样可以将大额超额费用分摊到每月多次结算,避免期末一次性大额账单。

成本管理最佳实践

- 定期监控:经常查看用量仪表盘,避免意外支出

- 设置预算:用套餐额度作为支出警戒线

- 优化流程:检查高成本执行,优化提示词或模型选择

- 选择合适模型:根据任务需求匹配模型复杂度

- 批量处理相似任务:尽量合并请求,减少额外开销